티스토리 뷰

728x90

https://www.youtube.com/watch?v=Dc0PQlNQhGY&t=1681s

해당 영상을 참고하였습니다.

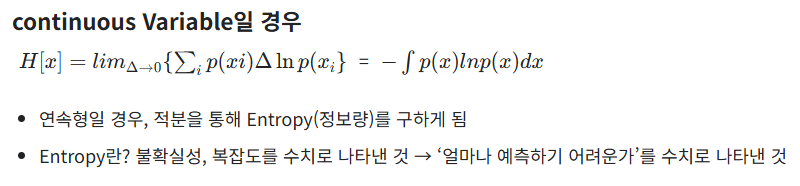

H의 정의

한가지 사건 일때

(가정) A→B에게 정보를 보내려고 한다 : 통신

ex)

해가 ‘동쪽’에서 떴다! 라는 소리는 당연한 소리 = 확률이 높은 상황 = 정보량이 없음( 당연함 )

해가 ‘서쪽’에서 떴다! 라는 정보 공유 = 확률이 낮은 상황 = 정보량이 엄청나게 큼 ( 희귀한 상황 ) (놀람의 정도 = 정보량)

h의 첫번째 조건

두가지 사건 일때

ex) 해가 동쪽에서 떴고, 서울에 비가 왔다.

정보1 → 해가 ‘동쪽’에서 떴다.

정보2 → 서울에 ‘비’가 왔다.

h의 두번째 조건

반응형

'Deep-learning' 카테고리의 다른 글

| [LLM] Fine-Tuning (0) | 2025.02.06 |

|---|---|

| [LLM] Tokenizer 기본 (0) | 2025.02.01 |

| [LLM] huggingface LLM 기본 내용 ( 양자화 ) (0) | 2025.01.30 |

| YOLOv11 이해하기 (4) - Loss (0) | 2024.11.19 |

| YOLOv11 이해하기 (3) - Head (0) | 2024.11.18 |

공지사항

최근에 올라온 글

최근에 달린 댓글

- Total

- Today

- Yesterday

링크

TAG

- YOLO

- 오블완

- GNN

- 뜯어보기

- 오류

- 딥러닝

- 이미지

- DeepLearning

- 파이썬

- YOLOv8

- 욜로

- yolov11

- GIT

- 티스토리챌린지

- 도커

- github

- V11

- python

- docker

- 알고리즘

- LLM

- Tree

- CNN

- 깃

- 초보자

- c3k2

- 정리

- 어탠션

- 자바

- java

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

글 보관함